Aktualisiert am:

Autor: Maximilian Bauer, Hörakustikmeister, MSc. Clinical Audiology

Das Ohr leitet Schall nur weiter. Verstehen entsteht erst im Gehirn. Das zentrale Hörsystem ist der Teil unseres Nervensystems, der Töne, Sprache und Geräusche in Bedeutung verwandelt – ein hochkomplexes Netzwerk, das ständig lernt, filtert und sich anpasst.

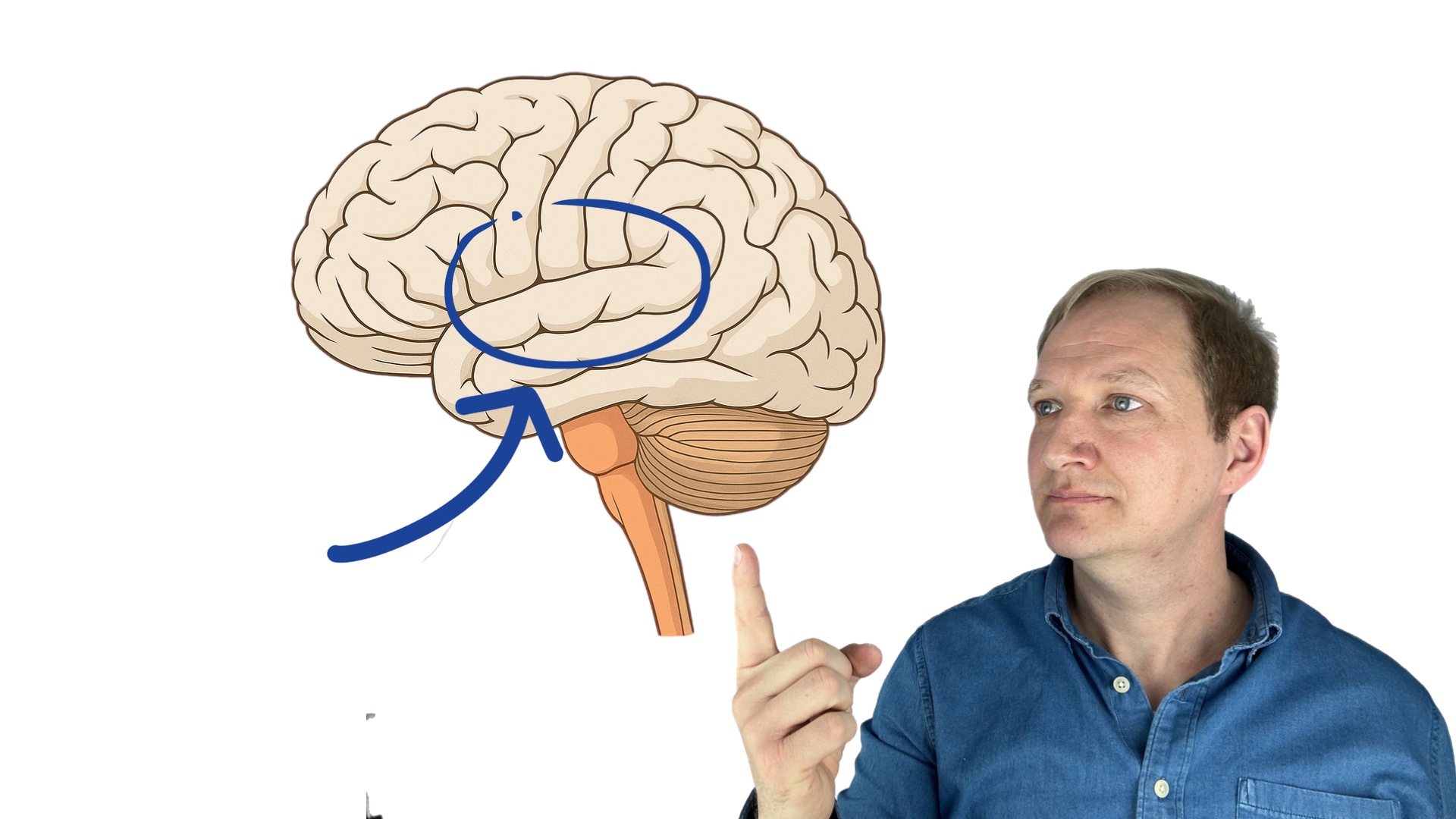

Vom Ohr ins Gehirn – der Weg des Klangs

Schallwellen erreichen das Innenohr, wo Haarzellen elektrische Impulse erzeugen. Diese Signale werden über den Hörnerv an den Hirnstamm geleitet. Dort übernehmen spezialisierte Nervenzellen, sogenannte Bushy Cells, die Aufgabe, die zeitliche Struktur der Signale mit hoher Präzision weiterzugeben. Sie leiten ihre Informationen an die oberen Olivenkerne weiter – den ersten Ort, an dem das Gehirn Schall aus beiden Ohren direkt vergleicht.

Wichtiger Unterschied LSO und MSO

Hinweis: In der lateralen oberen Olive (LSO) werden Lautstärkeunterschiede (ILDs), in der medialen oberen Olive (MSO) Laufzeitunterschiede (ITDs) ausgewertet. Diese beiden Mechanismen bilden die Basis der räumlichen Wahrnehmung.So entsteht ein neuronales Abbild, das dem Gehirn erlaubt, Richtung und Entfernung einer Schallquelle zu bestimmen. Die Information wird anschließend an den Colliculus inferior weitergeleitet, wo sie mit weiteren Klangmerkmalen zusammengeführt wird.

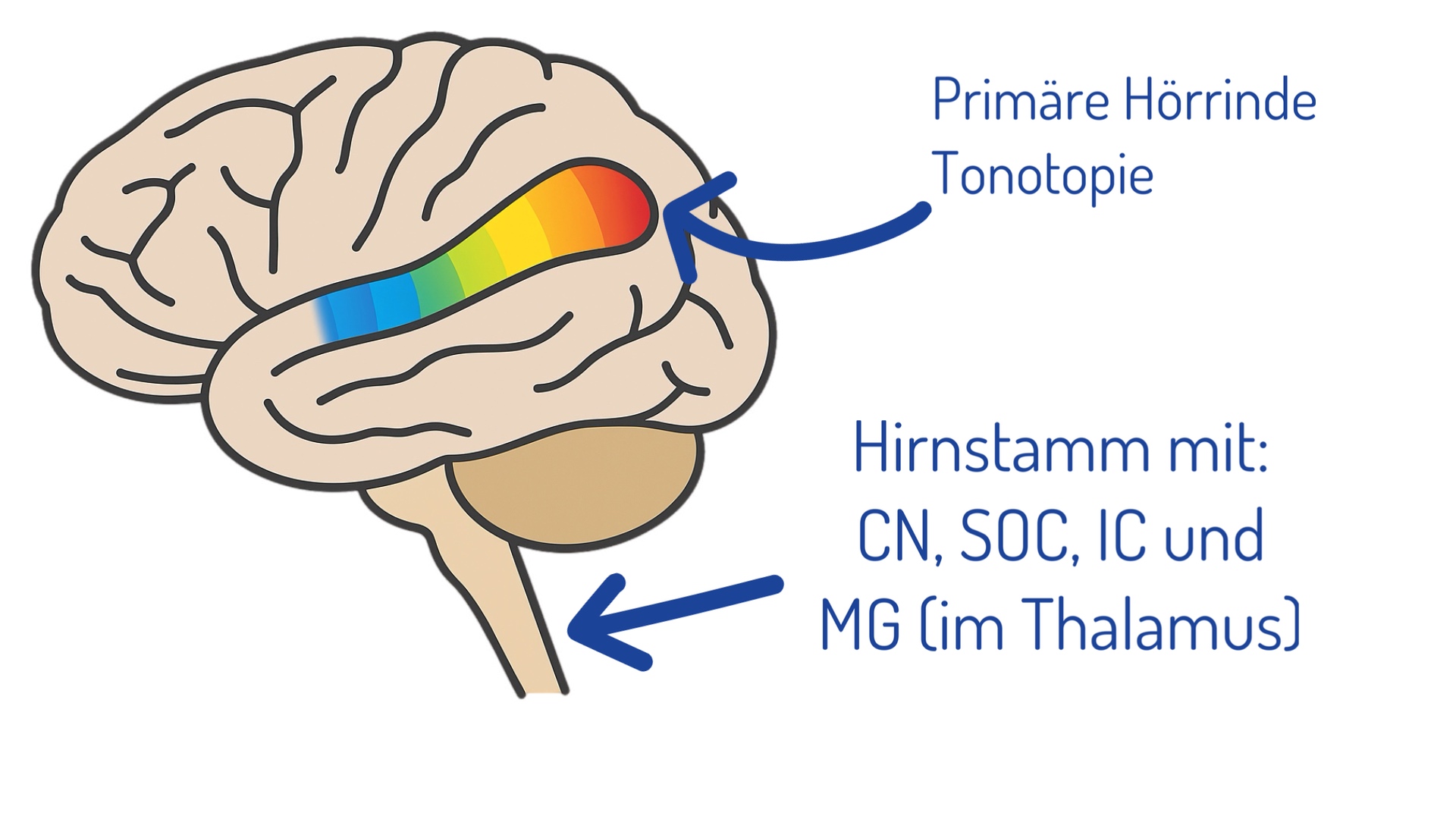

Tonotopie, Delay-Lines und das räumliche Hören

Im Inferior Colliculus sind die Neuronen nach Frequenz geordnet – diese Organisation nennt man Tonotopie. Zusätzlich entstehen hier komplexe „Karten“, die nicht nur Tonhöhen, sondern auch zeitliche Modulationen abbilden. Das Gehirn verknüpft diese Informationen zu einer Art Landkarte des Hörraums.

Das Jeffress-Modell

Besonderheit: Das sogenannte Jeffress-Modell (1948) beschreibt, wie das Gehirn minimale Laufzeitunterschiede von Mikrosekunden in neuronale Muster umsetzt. Später konnten Forscher wie Carr & Konishi (1988) diese „Delay-Lines“ im Tiermodell tatsächlich nachweisen.Im Ergebnis entsteht eine auditive Raumkarte – eine präzise neuronale Repräsentation, die es erlaubt, Geräusche zu orten, selbst wenn sie aus komplexen Umgebungen stammen.

Wie das Gehirn Sprache entziffert

Sprache ist ein akustisches Mosaik aus Frequenzen, Modulationen und Übergängen. Die vorderen Cochleariskerne und der Inferior Colliculus extrahieren die rhythmische Struktur (Amplitude-Modulation), während der auditive Cortex im Schläfenlappen daraus Bedeutungen konstruiert.

Jede Vokalkombination besitzt ihr eigenes Muster aus Formanten (F1, F2, F3). Neuronen im Cortex reagieren auf diese Muster und auf Bewegungen im Klang – etwa steigende oder fallende Frequenzverläufe, die wir als Konsonanten wahrnehmen.

Hochfrequenzen und Sprachverstehen

Empfehlung: Bei Hörverlusten oberhalb von 8 kHz gehen entscheidende Sprachanteile verloren. Moderne Hörgeräte sollten daher bis in die erweiterten Hochfrequenzen (EHFs) abgestimmt werden, um Sprachverstehen im Störlärm zu verbessern.Hören als Gehirnleistung: Aufmerksamkeit und Kontext

Ab hier verlässt das Hören die reine Signalverarbeitung. Im auditorischen Cortex werden Informationen mit Gedächtnis, Aufmerksamkeit und visuellen Eindrücken verknüpft. Ein klassisches Beispiel ist der McGurk-Effekt: Wenn Mundbewegung und Laut nicht zusammenpassen, „entscheidet“ sich das Gehirn für einen Kompromiss.

Ebenso entscheidend ist die Aufmerksamkeit. Magnetoenzephalographische Studien (Ding & Simon, 2012) zeigen: Das Gehirn verstärkt aktiv die Signale der Stimme, auf die wir uns konzentrieren – selbst wenn sie leiser ist als der Rest.

Kontext als kognitiver Verstärker

Hinweis: Kontext steigert Sprachverständnis dramatisch. Schon eine einfache Satzstruktur kann doppelt so viel Verstehen ermöglichen wie isolierte Wörter – ein Prinzip, das jede Hörrehabilitation berücksichtigen sollte.Die Konsequenzen für Hörgeräte und CI-Versorgung

Das zentrale Hören erklärt, warum ein gutes Audiogramm nicht automatisch gutes Verstehen bedeutet. Hörgeräte müssen nicht nur Lautstärke liefern, sondern das Gehirn entlasten, indem sie relevante Signale klar strukturieren. Ebenso wichtig ist ein Training, das Aufmerksamkeit, Gedächtnis und Kontextnutzung stärkt.

Neurokognitive Anpassung

Empfehlung: Eine moderne Anpassstrategie sollte zentrale Hörverarbeitung, Hörstress und neurokognitive Belastung explizit berücksichtigen – die klassische Verstärkung reicht nicht mehr aus.Fazit: Hören ist kein Sinn, sondern eine Gehirnleistung

Das Ohr ist nur der Anfang. Erst im Gehirn entsteht das, was wir als Klang, Sprache und Bedeutung wahrnehmen. Die zentrale Hörverarbeitung ist plastisch, trainierbar und lebenslang formbar – sie entscheidet, ob wir Lärm als Chaos oder als Sprache begreifen.

Wissenschaftliche Referenzen

- Pantev C. et al. (1989): Tonotopic Organization of the Auditory Cortex: Pitch Versus Frequency Representation. Science 246, 486–488. DOI: 10.1126/science.2814476

- Romani G.L. et al. (1982): Tonotopic Organization of the Human Auditory Cortex. Science 216, 1339–1340. DOI: 10.1126/science.7079770

- Talavage T.M. et al. (2004): Tonotopic Organization in Human Auditory Cortex Revealed by Progressions of Frequency Sensitivity. J Neurophysiol. DOI: 10.1152/jn.01125.2002